- Model bahasa besar PaLM 2 Google menggunakan hampir lima kali lebih banyak data tekstual untuk pelatihan seperti yang dipelajari pendahulunya, LLM, CNBC.

- Saat mengumumkan PaLM 2 minggu lalu, Google mengatakan modelnya lebih kecil dari PaLM sebelumnya tetapi menggunakan “teknologi” yang lebih efisien.

- Kurangnya transparansi tentang data pelatihan dalam model AI telah menjadi topik yang semakin hangat di kalangan peneliti.

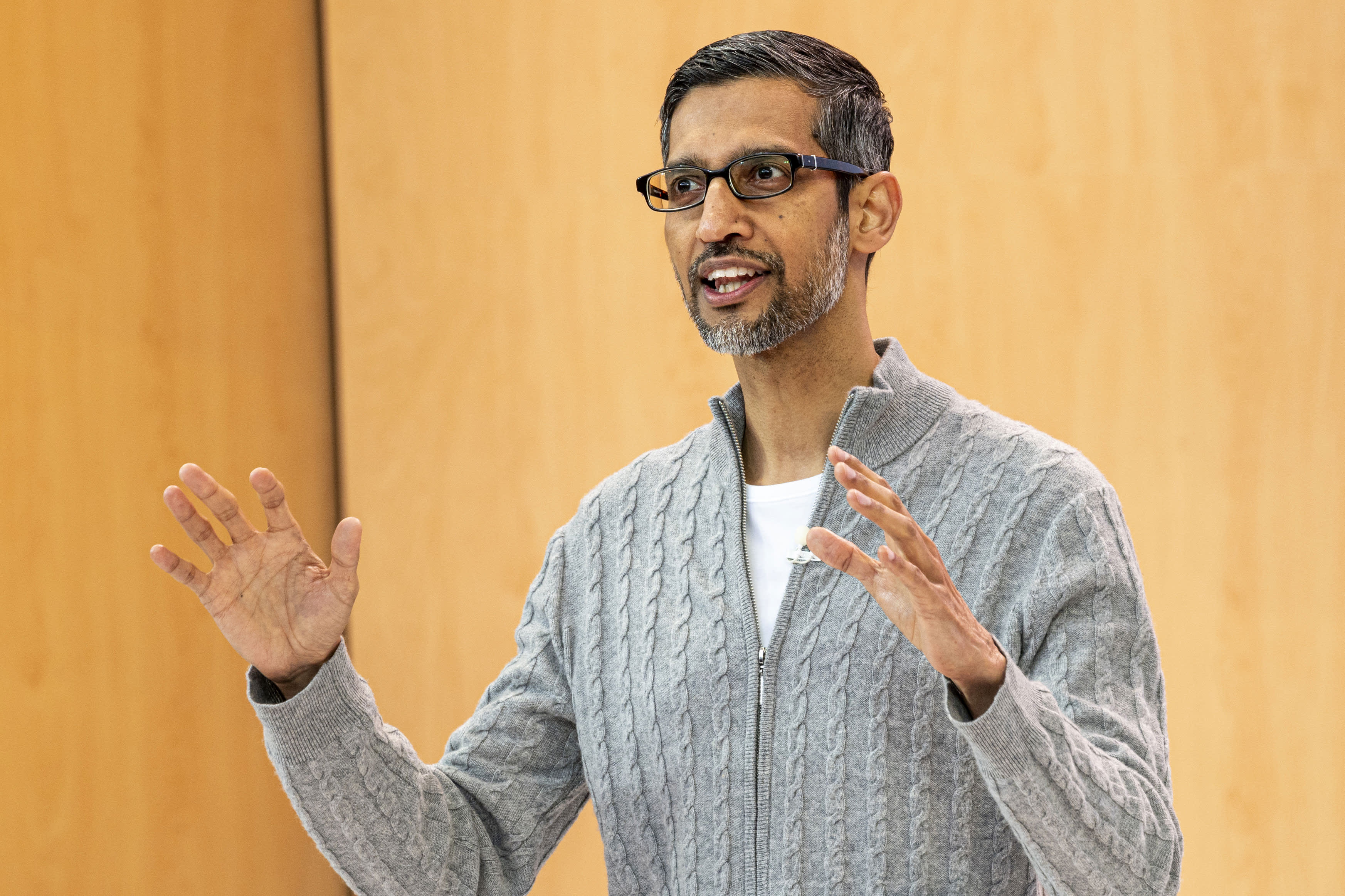

Sundar Pichai, CEO, Alphabet Inc. , selama Google I/O Developers Conference di Mountain View, California, pada Rabu, 10 Mei 2023.

David Paul Morris | bloomberg | Gambar Getty

CNBC telah mengetahui bahwa model bahasa besar baru Google, yang diumumkan perusahaan minggu lalu, menggunakan data pelatihan hampir lima kali lebih banyak daripada pendahulunya dari tahun 2022, memungkinkannya untuk melakukan tugas pengkodean, matematika, dan penulisan kreatif yang lebih canggih.

PaLM 2, model bahasa besar penggunaan publik (LLM) baru perusahaan yang diluncurkan di Google I/O, telah dilatih dengan 3,6 triliun token, menurut dokumen internal yang dilihat oleh CNBC. Token, yang merupakan rangkaian kata, merupakan blok bangunan penting untuk pelatihan LLM, karena mengajarkan model untuk memprediksi kata berikutnya yang akan muncul secara berurutan.

PaLM versi Google sebelumnya, yang merupakan singkatan dari Pathways Language Model, dirilis pada tahun 2022 dan dilatih dengan 780 miliar token.

Sementara Google sangat ingin menunjukkan kekuatan teknologi AI-nya dan bagaimana itu dapat diintegrasikan ke dalam pencarian, email, pengolah kata, dan spreadsheet, perusahaan tidak mau mempublikasikan volume atau detail lain dari data pelatihannya. OpenAI, inovator ChatGPT yang didukung Microsoft, juga merahasiakan detail bahasa LLM terbaru yang disebut GPT-4.

Perusahaan mengatakan alasan kurangnya pengungkapan adalah sifat persaingan bisnis. Google dan OpenAI sedang terburu-buru untuk menarik pengguna yang mungkin ingin mencari informasi menggunakan chatbot daripada mesin pencari tradisional.

Namun saat perlombaan senjata AI berkecamuk, komunitas riset menyerukan lebih banyak transparansi.

Sejak mengungkapkan PaLM 2, Google mengatakan model baru ini lebih kecil dari LLM sebelumnya, yang signifikan karena itu berarti teknologi perusahaan menjadi lebih efisien sambil menyelesaikan tugas yang lebih kompleks. PaLM 2 dilatih, menurut dokumentasi internal, pada 340 miliar parameter, yang merupakan indikasi kompleksitas model. PaLM awal dilatih pada 540 miliar parameter.

Google tidak segera memberikan komentar untuk cerita ini.

Google Dia berkata Dalam postingan blog tentang PaLM 2, model tersebut menggunakan “teknik baru” yang disebut Optimasi Skala Komputasi. Ini membuat LLM “lebih efisien dengan kinerja keseluruhan yang lebih baik, termasuk inferensi yang lebih cepat, parameter layanan yang lebih sedikit, dan biaya layanan yang lebih rendah.”

Saat mengumumkan PaLM 2, Google mengonfirmasi laporan CNBC sebelumnya bahwa model tersebut dilatih dalam 100 bahasa dan melakukan berbagai tugas. Ini sudah digunakan untuk mendukung 25 fitur dan produk, termasuk Bard chatbot eksperimental perusahaan. Ini tersedia dalam empat ukuran, dari yang terkecil hingga yang terbesar: Gecko, Otter, Bison, dan Unicorn.

PaLM 2 lebih kuat dari model mana pun yang ada, berdasarkan pengungkapan publik. LLM di Facebook disebut LLaMA, yaitu mengumumkan Pada bulan Februari, itu dilatih dengan 1,4 triliun token. Terakhir kali OpenAI membagikan volume pelatihan ChatGPT adalah dengan GPT-3, ketika perusahaan mengatakan telah melatih 300 miliar kode pada waktu itu. OpenAI merilis GPT-4 pada bulan Maret, dan mengatakan itu menunjukkan “kinerja tingkat manusia” dalam beberapa tes profesional.

LaMDA, percakapan LLM bahwa Google kaki Dua tahun lalu dan dipromosikan pada bulan Februari bersama Bard, telah dilatih dengan 1,5 triliun token, menurut dokumen terbaru yang dilihat oleh CNBC.

Karena aplikasi AI baru dengan cepat mencapai arus utama, begitu pula perdebatan tentang teknologi yang mendasarinya.

Mehdi Elmohamady, Ilmuwan Riset Senior di Google, Dia mengundurkan diri pada bulan Februari Tentang kurangnya transparansi perusahaan. Pada hari Selasa, CEO OpenAI Sam Altman bersaksi di sidang Subkomite Kehakiman Senat tentang Privasi dan Teknologi, dan setuju dengan anggota parlemen bahwa sistem baru diperlukan untuk menangani AI.

“Untuk teknologi yang sangat baru, kami memerlukan kerangka kerja baru,” kata Altman. “Tentu saja perusahaan seperti kami memiliki banyak tanggung jawab atas alat yang kami keluarkan ke dunia.”

— Jordan Novette dari CNBC berkontribusi pada laporan ini.

Dia menonton: Sam Altman, CEO OpenAI, telah menyerukan penatalayanan AI

“Communication. Music lover. Certified bacon pioneer. Travel supporter. Charming social media fanatic.”

More Stories

Di tengah ketidakpastian jadwal, Boeing akan memberhentikan pekerja di program roket SLS

Microsoft Xbox telah mengakuisisi PlayStation Store Sony 🤯

Supergiant memamerkan gameplay Hades II dan desain dewa baru